In order to get the DEB packages for Ubuntu, it’s needed to register and you’ll get an e-mail with the links to download them. Once all the packages are in the Chef Server, the installation can start.

Chef Server

sudo update-rc.d apache2 disable

sudo private-chef-ctl reconfigure

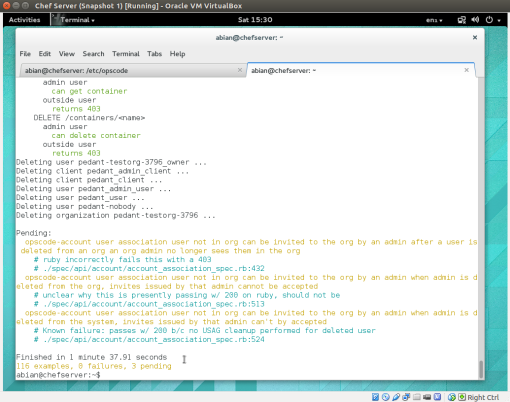

sudo private-chef-ctl test

sudo dpkg -i opscode-reporting_1.1.6-1_amd64.deb

sudo opscode-reporting-ctl reconfigure

sudo private-chef-ctl restart opscode-reporting

sudo opscode-reporting-ctl test

sudo dpkg -i opscode-push-jobs-server_1.1.3-1_amd64.deb

sudo opscode-push-jobs-server-ctl reconfigure

opscode-push-jobs-server-ctl test

Don’t use root for running the previous commands or there will be an error. I got rid of the error just by using sudo as it’s explained in the documentation.

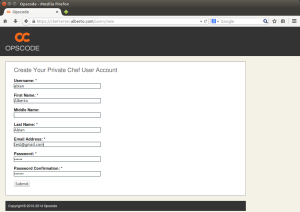

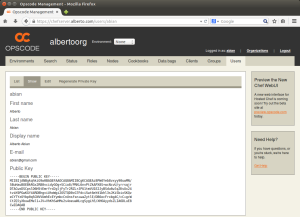

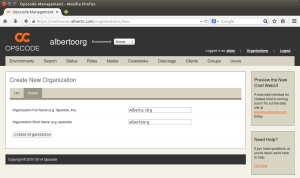

User and Organization

Chef Workstation

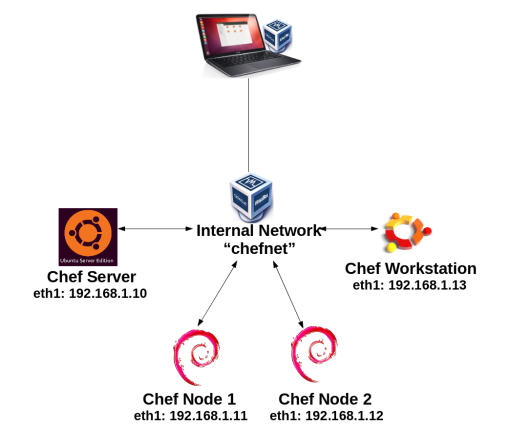

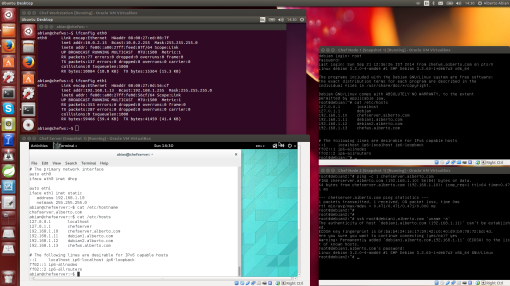

As the Chef Workstation is an Ubuntu Desktop, I can use «sudo apt-get install chef» for installing the chef client. In my example, I’m using again https://chefserver.alberto.com as the Chef Server URL. Remember that I have added all the IPs and names in the /etc/hosts file.

The Chef Development Kit is also needed in the Worksation:

sudo dpkg -i chefdk_0.2.2-1_amd64.deb

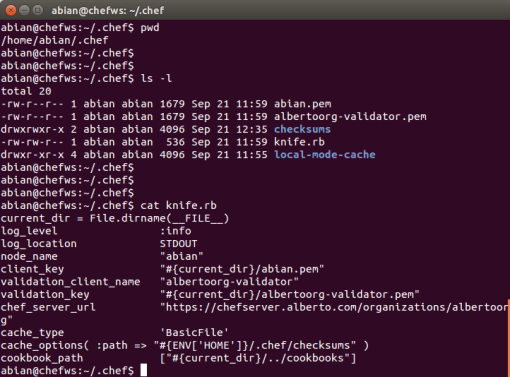

I need to copy the user key file, the organization validation file and the initial knife configuration file to the Chef Workstation. I have copied them into /home/abian/.chef as it can be seen in the following screenshot:

The content of the knife.rb should be something like this

abian@chefws:~/.chef$ cat knife.rb

current_dir = File.dirname(__FILE__)

log_level :info

log_location STDOUT

node_name «abian»

client_key «#{current_dir}/abian.pem»

validation_client_name «albertoorg-validator»

validation_key «#{current_dir}/albertoorg-validator.pem»

chef_server_url ‘https://chefserver.alberto.com/organizations/albertoorg’

cache_type ‘BasicFile’

cache_options( :path => «#{ENV[‘HOME’]}/.chef/checksums» )

cookbook_path [«#{current_dir}/../cookbooks»]

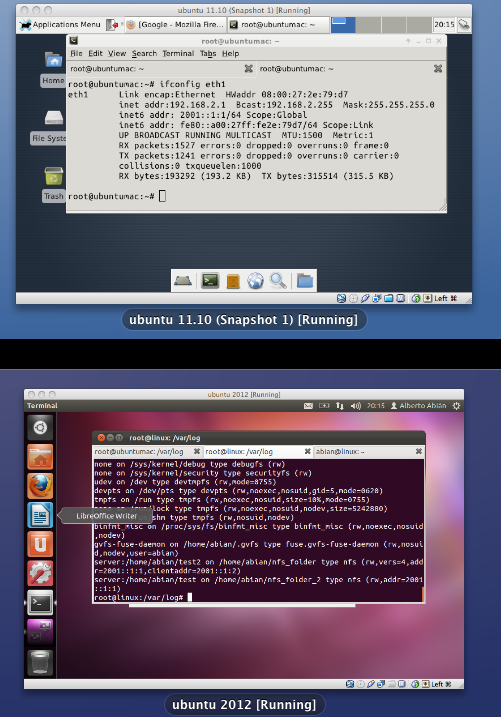

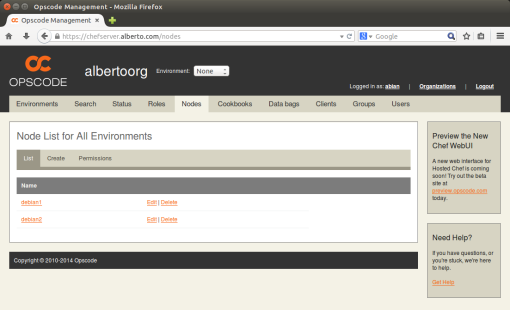

Chef Nodes

– Add sources.list: sudo echo ‘deb http://ftp.ie.debian.org/debian/ testing non-free contrib main’ >> /etc/apt/sources.list

– Check that it doesn’t break anything: sudo apt-get -t testing install libc6-dev –dry-run

– Install the new version: sudo apt-get -t testing install libc6-dev

knife bootstrap debian1.alberto.com -x root -P password -N debian1

knife bootstrap debian2.alberto.com -x root -P password -N debian2

The environment is ready for the addition of cookbooks and recipes.

The environment is ready for the addition of cookbooks and recipes.